Een mens zou moeten beslissen als het gaat om zaken van leven of dood

Van medische diagnoses tot autonome wapens in het Midden-Oosten: ArtificiaI Intelligence (AI) neemt steeds meer beslissingen zelf, zonder dat er nog een mens aan te pas komt. Rineke Verbrugge, Hoogleraar Logica en Cognitie aan de Rijksuniversiteit Groningen, vindt dat dat anders moet: AI zou een aanvulling moeten zijn op menselijke intelligentie, niet een vervanging ervan. Ze is mede-oprichter van het Hybrid Intelligence Centre, dat nu vijf jaar bestaat en onlangs groen licht kreeg voor de volgende vijf jaar.

FSE Science Newsroom | Tekst Charlotte Vlek | Beeld Leoni von Ristok

Computers kunnen razendsnel patronen herkennen, grote hoeveelheden data analyseren, en ze kunnen ons helpen objectief te blijven. Maar om de menselijke waarden en normen te behouden, moet er altijd een mens in de loop zijn, vindt Verbrugge. ‘Denk aan medische diagnoses: daar is AI heel goed in, bijvoorbeeld door beelden van MRI-scans te analyseren. Maar als het gaat om zaken van leven of dood zou een mens wel de uiteindelijke beslissing moeten nemen.’

De missie van het Hybrid Intelligence Centre is daarom AI-systemen te ontwerpen die kunnen fungeren als een extensie van ons menselijke verstand. Dat betekent dat het systeem niet zomaar een eindoordeel uitspuugt – een medische diagnose of de kortste route naar huis – maar kan samenwerken met en aanpassen aan mensen, verantwoorde keuzes kan maken en kan uitleggen waarom het die keuzes maakt. Dan zou een arts samen met het AI-algoritme een diagnose kunnen stellen, op basis van data én gesprekken met de patiënt.

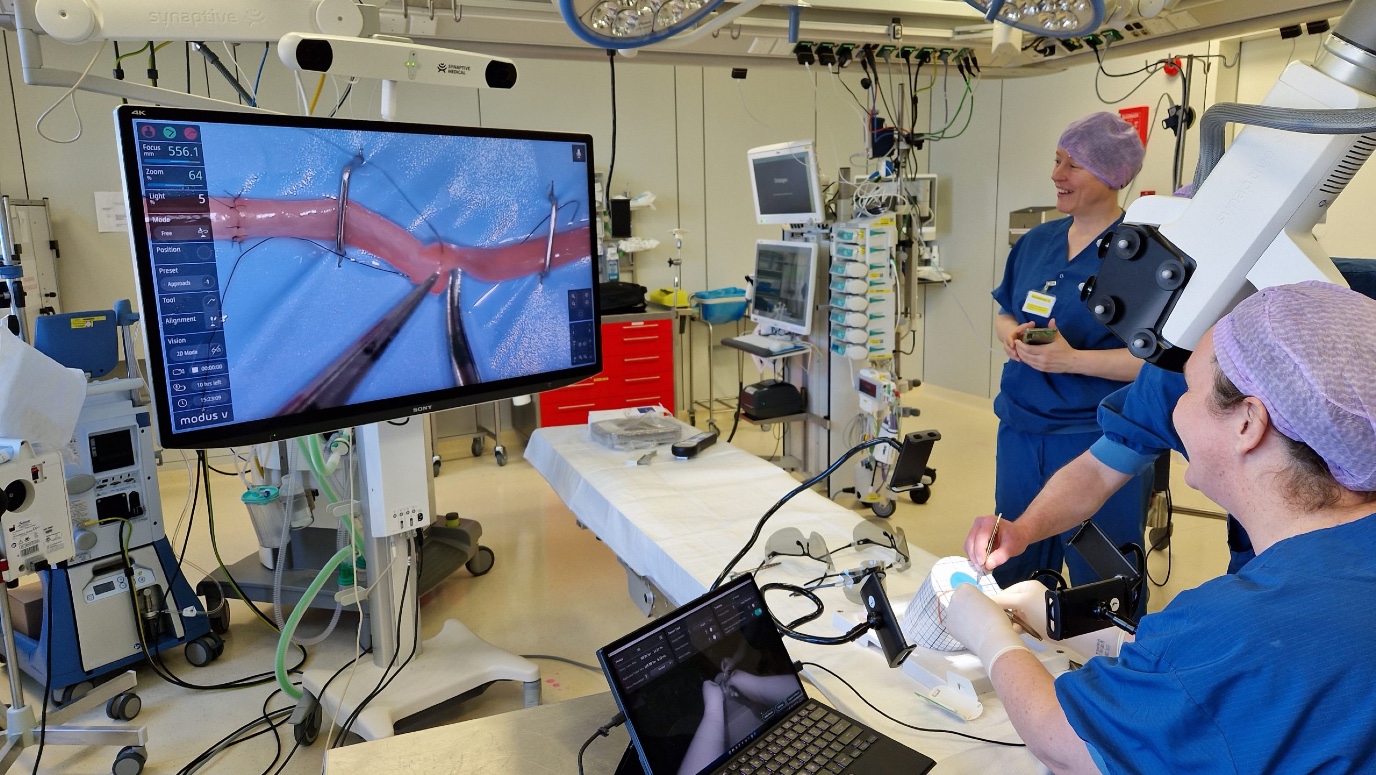

Een coöperatieve robotarm

Het Hybrid Intelligence Centre doet al zijn onderzoek altijd met het oog op specifieke toepassingen, vertelt Verbrugge. ‘We zijn nu vijf jaar bezig, en over nog eens vijf jaar hopen we die toepassingen zo ver gebracht te hebben dat anderen het op de markt kunnen brengen.’ De toepassingen lopen uiteen van een robotsuppoost die in een museum vragen van bezoekers kan beantwoorden, tot een robotarm die een chirurg bijstaat tijdens de operatie.

Over nog eens vijf jaar hopen we die toepassingen zo ver gebracht te hebben dat anderen het op de markt kunnen brengen.

‘Zo’n robotarm heeft een camera en maakt voor de chirurg close-up beeld dat op een beeldscherm getoond wordt. Dan is het handig als de robotarm anticipeert op wat de chirurg gaat doen, of even overlegt: “vind je het handig als ik straks even van de andere kant kijk?”’ Ook zou zo’n robotarm kunnen inschatten wanneer een chirurg moe begint te worden, en hem dan kunnen adviseren: misschien is het tijd je te laten vervangen. ‘Maar dat accepteert zo’n chirurg natuurlijk nooit!’ lacht Verbrugge. En daarom is het belangrijk dat Hybrid Intelligence ook begrijpt hoe mensen in elkaar steken.

Wat een ander denkt dat jij denkt

Computers zijn als geleerde dwazen: ze zijn ontzettend goed in slechts een smal domein, maar de vaardigheid om beweegredenen van mensen te doorgronden ontbreekt. Het is iets dat een kind van ongeveer vier jaar oud al wel kan: theory of mind, het kunnen redeneren over de gedachten, intenties en overtuigingen van een ander. Verbrugge doet al bijna twintig jaar onderzoek naar het onderwerp.

De Sally-Anne taak

De klassieke test om theory of mind bij kinderen te onderzoeken bestaat uit een kort verhaaltje over Sally en Anne. Sally stopt een knikker in haar mandje, en gaat dan de kamer uit. Als ze weg is, haalt Anne de knikker uit het mandje en stopt die in een doosje. Dan komt Sally de kamer weer in. Een jong proefpersoontje krijgt nu de vraag: ‘Waar denkt Sally dat haar knikker verstopt is?’

Een kind dat nog geen theory of mind heeft ontwikkeld, zal antwoorden dat Sally haar knikker in het doosje zal zoeken, want het kind weet zelf immers dat daar die knikker zit. Dat Sally dat niet weet, begrijpt ze nog niet. Een kind dat zogenaamde eerste orde theory of mind heeft, zal zeggen dat Sally in haar mandje zal zoeken, daar heeft ze de knikker immers achtergelaten voor ze de kamer uit ging!

Deze opgave wordt een slagje moeilijker (tweede orde theory of mind) als de vraag niet gaat over wat Sally denkt, maar over wat Sally denkt dat Anne denkt. Bijvoorbeeld: waar denkt Sally dat Anne denkt dat de knikker is? Verbrugge legt uit dat theory of mind heel domein-specifiek is. Een verhaaltjestest lukt dan bijvoorbeeld wel in de tweede orde, maar bij een spelletje redeneren over wat de tegenspeler denkt dat jij denkt dat zij gaat doen, lukt nog niet.

Een robot in een team van mensen

Verbrugge bestudeert theory of mind vanuit een unieke combinatie van logica en cognitiewetenschap. Samen met computerwetenschappers, psychologen en taalkundigen achterhaalt Verbrugge hoe mensen theory of mind toepassen, en wanneer ze de mist in gaan. Het doel: door te begrijpen hoe mensen deze vaardigheid leren, zou je het ook aan een computer kunnen leren. Het er simpelweg in programmeren gaat namelijk niet, legt Verbrugge uit. ‘Je zou een computer wel kunnen programmeren om over een mens te redeneren als die perfect logisch in elkaar steekt, maar we zijn als mensen nu eenmaal niet perfect. Verre van, zelfs.’

Je zou een computer wel kunnen programmeren om over een mens te redeneren als die perfect logisch in elkaar steekt, maar we zijn als mensen nu eenmaal niet perfect. Verre van, zelfs.

Mensen willen bijvoorbeeld niet altijd met elkaar samenwerken, of hebben niet altijd goede intenties. Dat is vooral ingewikkeld voor AI wanneer het in een gemengd team met mensen moet leren samenwerken. Bijvoorbeeld omdat de één graag promotie wil maken, waardoor een ander niet met diegene wil werken. ‘Een AI die dat begrijpt, kan beter met die mensen samenwerken.’

Daarom onderzoeken promovendi van Verbrugge bijvoorbeeld hoe binnen een groep mensen zogenaamde ‘common ground’ kan ontstaan: de (on)geschreven regels waarvan iedereen op de hoogte is. Dat kan gaan over het gedrag van deelnemers aan een spel, fietsers bij een stoplicht dat alle kanten tegelijk op groen laat springen, of over privacy: wanneer is het sociaal acceptabel om een foto van een vriend(in) te delen op Facebook? En hoe kom je er eigenlijk achter wanneer een mens liegt, kun je dat ook aan een klein kind leren? En aan een computer?

De volgende generatie AI-onderzoekers

Verbrugge vindt het belangrijk om ook buiten haar onderzoeksgroep jonge AI-onderzoekers te bereiken met de visie van het Hybrid Intelligence Centre. Als Director of Training and Eduction organiseert ze tweewekelijkse bijeenkomsten over Hybrid Intelligence voor promovendi van het onderzoekscentrum, en cursussen waar ook promovendi van daarbuiten welkom zijn. En de RUG krijgt binnenkort zelfs als eerste universiteit in de wereld een afstudeerrichting Hybrid Intelligence binnen de Masteropleiding AI. Verbrugge: ‘Voor studenten die houden van programmeren, maar wel met oog voor de mens.’

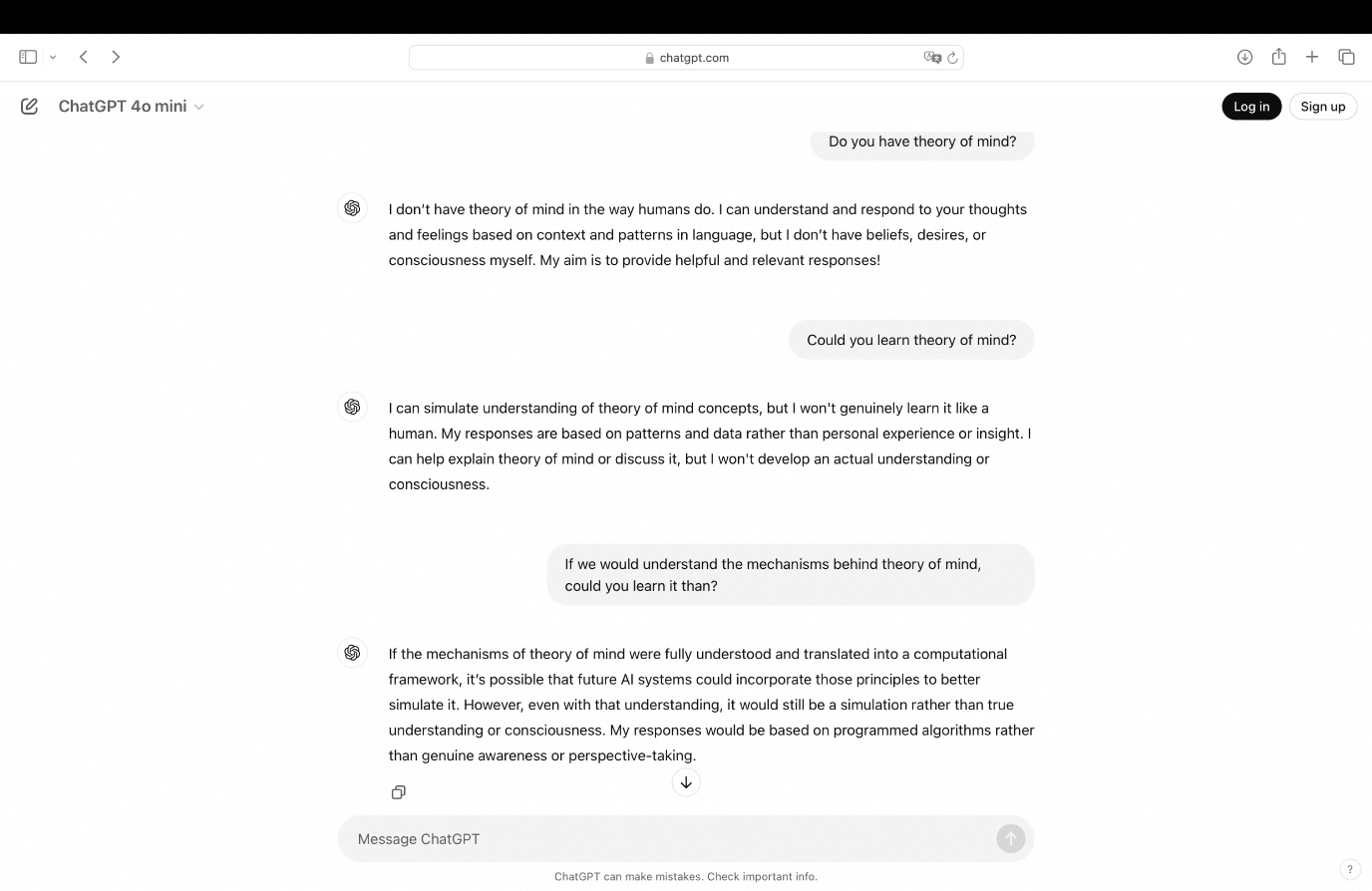

Heeft ChatGPT theory of mind?

‘Theory of mind is momenteel een beetje een buzzword binnen de AI,’ vertelt Verbrugge. Kan bijvoorbeeld een groot taalmodel zoals ChatGPT theory of mind ontwikkelen? Om dat te testen, schotelden onderzoekers een verhaaltjestest (zie kader: Sally-Anne taak) voor aan zo’n chatmodel. Wat bleek? Het taalmodel had het antwoord goed! ‘Maar,’ vertelt Verbrugge, ‘er staan natuurlijk talloze voorbeelden van deze verhaaltjestests op het internet, waar het taalmodel het antwoord vandaan kan halen.’

Harmen de Weerd, assistant professor in de groep van Verbrugge, legt uit: ‘Bij een kleine variatie in het verhaaltje gaat het taalmodel al onderuit. Als Anne bijvoorbeeld de knikker van Sally in een doorzichtig doosje stopt, denkt de AI nog steeds dat Sally niet weet dat haar knikker verplaatst is. Terwijl een kind wel kan begrijpen dat Sally die knikker in het doorzichtige doosje gewoon ziet liggen.’ ChatGPT is wat dat betreft voorlopig dus nog een peuter.

| Laatst gewijzigd: | 13 februari 2025 14:16 |

Meer nieuws

-

15 april 2025

Nathalie Katsonis wint Ammodo Science Award 2025

Voor haar baanbrekende onderzoek naar moleculaire systemen ontvangt Nathalie Katsonis de Ammodo Science Award for fundamental research 2025.

-

15 april 2025

Fundamenteel onderzoek met levensgrote effecten

Nathalie Katsonis wint de Ammodo Science Award for Fundamental Research. Ze ontwikkelt adaptieve moleculaire materialen en onderzoekt de chemische oorsprong van leven, wat ook weer inzichten oplevert voor vaccins en het opruimen van olievlekken op...

-

14 april 2025

Plastic recycling: met dank aan bacteriën

Edita Jurak zoekt bacteriën waarvan de enzymen nuttig zijn bij het recyclen, maar ook bij het opruimen van plastics in de natuur.